Definición de tarjeta de video

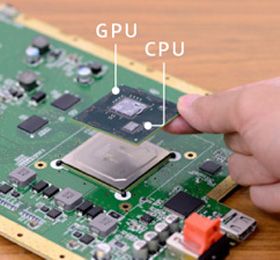

Una tarjeta de vídeo, también llamada tarjeta gráfica (entre otros nombres) tiene a su cargo el procesamiento de los datos que provienen del procesador principal (CPU o UCP) y convertirlos en información que se pueda representar en dispositivos tales como los monitores y los televisores. Cabe mencionar que este componente puede presentar una gran variedad de arquitecturas, aunque comúnmente se denominan de igual forma, incluso si se habla de un chip de vídeo integrado en una placa madre (motherboard); en este último caso, es más correcto decir GPU (Unidad de Procesamiento Gráfico).

Una tarjeta de vídeo, también llamada tarjeta gráfica (entre otros nombres) tiene a su cargo el procesamiento de los datos que provienen del procesador principal (CPU o UCP) y convertirlos en información que se pueda representar en dispositivos tales como los monitores y los televisores. Cabe mencionar que este componente puede presentar una gran variedad de arquitecturas, aunque comúnmente se denominan de igual forma, incluso si se habla de un chip de vídeo integrado en una placa madre (motherboard); en este último caso, es más correcto decir GPU (Unidad de Procesamiento Gráfico).

Desde su concepción, las tarjetas gráficas han incluido diversas prestaciones y funciones, tales como la posibilidad de sintonizar la televisión o de capturar secuencias de vídeo de un aparato externo. Es importante notar que no se trata de un componente hallado exclusivamente en los ordenadores actuales, sino que han existido desde hace ya más de cuatro décadas y hoy en día también son parte indispensable de las consolas de videojuegos, tanto de las portátiles como de las caseras.

Su creación data del final de la década del 60, época en la cual se dejó atrás el uso de una impresora para visualizar la actividad de los ordenadores y se comenzó a usar monitores. Al principio, las resoluciones eran ínfimas en comparación a la ya conocida por todos alta definición. Fue gracias al trabajo de investigación y desarrollo de Motorola que las características de los chips se volvieron más complejas y sus productos dieron pie a que se estandarizara el nombre de tarjetas de vídeo.

A medida que los ordenadores para uso personal y las primeras consolas de videojuegos se hicieron populares, se optó por integrar los chips gráficos en las placas madre, dado que esto permitía disminuir considerablemente los costes de fabricación. A simple vista, esto presenta una clara desventaja: la imposibilidad de actualizar el equipo; sin embargo, se trataba de sistemas cerrados, que eran construidos tomando en consideración todos y cada uno de sus componentes, de forma que el producto final fuera consistente y ofreciera el mayor rendimiento posible.

Cabe alcarar que al día de hoy esto sigue sucediendo con las consolas, y es gracias a este tipo de diseño inalterable que luego de unos años los desarrolladores obtengan resultados muy superiores a los primeros experimentos; esto no es posible en una PC, por poderosa que sea, dado que una compañía de software no puede considerar todas las combinaciones posibles de las máquinas de sus consumidores. Además, la arquitectura de un ordenador tiene puntos débiles justamente debido a que sus partes son intercambiables, siendo el más notable la distancia que existe entre la memoria, la tarjeta gráfica y el procesador principal.

Cabe alcarar que al día de hoy esto sigue sucediendo con las consolas, y es gracias a este tipo de diseño inalterable que luego de unos años los desarrolladores obtengan resultados muy superiores a los primeros experimentos; esto no es posible en una PC, por poderosa que sea, dado que una compañía de software no puede considerar todas las combinaciones posibles de las máquinas de sus consumidores. Además, la arquitectura de un ordenador tiene puntos débiles justamente debido a que sus partes son intercambiables, siendo el más notable la distancia que existe entre la memoria, la tarjeta gráfica y el procesador principal.

A comienzos de los años 80, IBM se basó en el diseño del inolvidable Apple II y consiguió que la tarjeta de vídeo intercambiable se volviera popular, aunque en su caso sólo ofrecía la posibilidad de mostrar caracteres en pantalla. Se trataba de un adaptador con la modesta cantidad de 4KB de memoria (en la actualidad pueden tener 2GB, 512 veces más) y que se utilizaba con un monitor monocromático. Este fue el punto de partida, y las mejoras no se hicieron esperar mucho.

Tiempo después, IBM estandarizó el término VGA, que se refiere a una tecnología de tarjetas de vídeo capaces de ofrecer una resolución de 640 píxeles de ancho por 480 de alto, así como a los monitores que podían representar dichas imágenes y al conector necesario para su uso. Luego del trabajo de varias empresas dedicadas exclusivamente a la gráfica, Super VGA (también conocido como SVGA) vio la luz del día, aumentando la definición disponible (a 1024 x 768) así como la cantidad de colores que podían ser representados de forma simultánea (de 16 colores en 640 x 480 se pasó a 256 en 1024 x 768).