Definición de entropía

Entropía es una noción que procede de un vocablo griego que puede traducirse como “vuelta” o “transformación” (utilizado en sentido figurado).

Entropía es una noción que procede de un vocablo griego que puede traducirse como “vuelta” o “transformación” (utilizado en sentido figurado).

En el siglo XIX Clausius acuñó el concepto en el ámbito de la Física para referirse a una medida del desorden que puede verse en las moléculas de un gas. A partir de entonces este concepto se utilizaría con diversos significados en múltiples ciencias, tales como la física, la química, la informática, la matemática y la lingüística.

Algunas definiciones son:

La entropía puede ser la magnitud física termodinámica que permite medir la parte no utilizable de la energía contenida en un sistema. Esto quiere decir que dicha parte de la energía no puede usarse para producir un trabajo.

Se entiende por entropía también a la medida del desorden de un sistema. En este sentido, está asociada a un grado de homogeneidad.

La entropía de formación de un compuesto químico se establece midiendo la que conforma a cada uno de sus elementos constituyentes. A mayor entropía de formación, más favorable será su formación.

En la teoría de la información, la entropía es la medida de la incertidumbre que existe ante un conjunto de mensajes (de los cuales sólo se recibirá uno solo). Se trata de una medida de la información que es necesaria para reducir o eliminar la incertidumbre.

Otra manera de entender la entropía es como la cantidad media de información que contienen los símbolos transmitidos. Palabras como “el” o “que” son los símbolos más frecuentes en un texto pero, sin embargo, son los que aportan menos información. El mensaje tendrá información relevante y máxima entropía cuando todos los símbolos son igualmente probables.

La entropía en el campo de la lingüística

La forma en la que se organiza y difunde la información en un discurso es uno de los temas más relevantes y susceptibles de investigación para la lingüística. Y gracias a la entropía puede realizarse un análisis más profundo de la comunicación.

En el caso de la comunicación escrita el problema es sencillo de analizar (las unidades básicas, las letras, se encuentran bien definidas); si se desea comprender a fondo el mensaje es posible decodificarlo con exactitud y comprender tanto lo dicho literal como figurado. Pero en el lenguaje oral, la cosa cambia un poco, presentando algunas complicaciones.

No es sencillo determinar en el discurso oral los elementos fundamentales del código; las palabras suenan diferentes según por quién las pronuncie y, de igual modo, pueden tener significados diversos. No es suficiente por tanto clasificarlas en fonemas vocálicos y consonánticos porque esto no nos permitiría entender cómo se organiza la información porque, por ejemplo, si se suprimen fonemas vocálicos, no es posible comprender el mensaje.

No es sencillo determinar en el discurso oral los elementos fundamentales del código; las palabras suenan diferentes según por quién las pronuncie y, de igual modo, pueden tener significados diversos. No es suficiente por tanto clasificarlas en fonemas vocálicos y consonánticos porque esto no nos permitiría entender cómo se organiza la información porque, por ejemplo, si se suprimen fonemas vocálicos, no es posible comprender el mensaje.

Según un estudio realizado en la Universidad de Wisconsin-Madison una buena forma de aislar y comprender el código oral es a través de la descomposición espectral de las señales sonoras. Gracias a esta técnica se intenta comprender cómo la cóclea filtra y analiza lo le llega. La cóclea es la parte de nuestros oídos que tiene la función de transformar los sonidos en señales eléctricas y enviarlas directamente al cerebro.

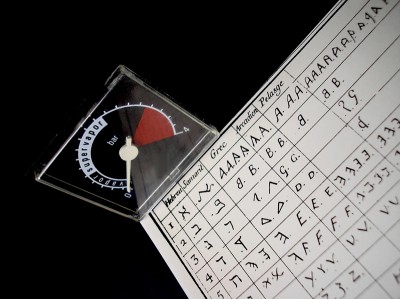

Para llevar a cabo este experimento se utilizó una unidad de medida que se conoce como entropía espectral en escala coclear (CSE), la misma permite establecer conexiones entre una señal y la que la precede; decidiendo qué posibilidades hay de predecir una señal partiendo de la anterior.

Los resultados devolvieron que cuanto más parecidas son dos señales, más fácil es predecir la segunda; esto significa que la información que tomamos de la segunda es casi nula. Así mismo cuanto más difieran entre sí, mayor será la información que aporte la segunda señal, por lo que si es eliminada provocará consecuencias considerables en la comprensión del discurso.