Multicolinealidad

La multicolinealidad es la relación de dependencia lineal fuerte entre más de dos variables explicativas en una regresión múltiple que incumple el supuesto de Gauss-Markov cuando es exacta.

En otras palabras, la multicolinealidad es la correlación alta entre más de dos variables explicativas.

Resaltamos que la relación lineal (correlación) entre variables explicativas tiene que ser fuerte. Es muy habitual que las variables explicativas de la regresión estén correlacionadas. Entonces, se debe puntualizar que esta relación debe ser fuerte, pero nunca perfecta, para que sea considerada un caso de multicolinealidad. La relación lineal sería perfecta si el coeficiente de correlación fuese 1.

Cuando esta fuerte relación lineal (pero no perfecta) se produce sólo entre dos variables explicativas, decimos que se trata de un caso de colinealidad. Sería multicolinealidad cuando la relación lineal fuerte se produce entre más de dos variables independientes.

El supuesto de Gauss-Markov sobre no multicolinealidad exacta define que las variables explicativas en una muestra no pueden ser constantes. Además, no deben existir relaciones lineales exactas entre variables explicativas (no multicolinealidad exacta). Gauss-Markov no nos permite la multicolinealidad exacta, pero si la multicolinealidad aproximada.

Aplicaciones

Existen casos muy particulares, normalmente poco realistas, en los cuales las variables de la regresión están completamente incorrelacionadas entre ellas. En estos casos hablamos de exogeneidad de las variables explicativas. Generalmente las ciencias sociales son famosas por incorporar multicolinealidad aproximada en sus regresiones.

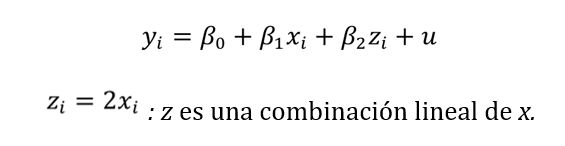

Multicolinealidad exacta

La multicolinealidad exacta se produce cuando más de dos variables independientes son una combinación lineal de otras variables independientes de la regresión.

Problemas

Cuando Gauss Markov prohibe la multicolinealidad exacta es porque no podemos obtener el estimador de Mínimos Cuadrados Ordinarios (MCO).

Matemáticamente expresando la beta estimada sub-i en forma matricial:

Entonces si hay multicolinealidad exacta provoca que la matriz (X’X) tenga determinante 0 y, por tanto, no sea invertible. No ser invertible implica no poder calcular (X’X)-1 y en consecuencia tampoco Beta estimada sub-i.

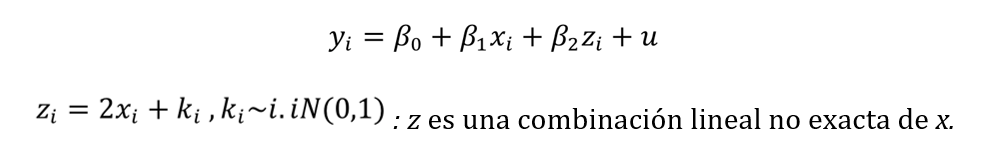

Multicolinealidad aproximada

La multicolinealidad aproximada se produce cuando más de dos variables independientes no son exactamente (aproximación) una combinación lineal de otras variables independientes de la regresión.

La variable k representa una variable aleatoria (independiente e idénticamente distribuida (i.i.d)). La frecuencia de sus observaciones puede aproximarse satisfactoriamente a una distribución Normal estándar de media 0 y varianza 1. Dado que es una variable aleatoria implica que en cada observación i, el valor de k va a ser distinto e independiente de cualquier valor anterior.

Problemas

Matemáticamente expresando en forma matricial:

Entonces si hay multicolinealidad aproximada provoca que la matriz (X’X) sea aproximadamente 0 y que el coeficiente de determinación muy cercano a 1.

Solución

La multicolinealidad puede reducirse con la eliminación de los regresores de las variables con alta relación lineal entre ellas.